Upload 12 files

Browse files- .gitattributes +3 -0

- Benchmark MLLM.ipynb +0 -0

- LICENSE.txt +8 -0

- Multimodality in Large Language Models.md +197 -0

- README.md +56 -12

- Summary for arXiv.pdf +3 -0

- app.py +136 -0

- img/Readme.jpg +0 -0

- img/benchmark.png +3 -0

- img/mllm_architecture_diagram.png +3 -0

- img/wijaya_introduction_nextgpt_anytoany_multimodal_large_language_model_4.webp +0 -0

- requirements.txt +8 -0

- results/benchmark_results.csv +157 -0

.gitattributes

CHANGED

|

@@ -33,3 +33,6 @@ saved_model/**/* filter=lfs diff=lfs merge=lfs -text

|

|

| 33 |

*.zip filter=lfs diff=lfs merge=lfs -text

|

| 34 |

*.zst filter=lfs diff=lfs merge=lfs -text

|

| 35 |

*tfevents* filter=lfs diff=lfs merge=lfs -text

|

|

|

|

|

|

|

|

|

|

|

|

| 33 |

*.zip filter=lfs diff=lfs merge=lfs -text

|

| 34 |

*.zst filter=lfs diff=lfs merge=lfs -text

|

| 35 |

*tfevents* filter=lfs diff=lfs merge=lfs -text

|

| 36 |

+

img/benchmark.png filter=lfs diff=lfs merge=lfs -text

|

| 37 |

+

img/mllm_architecture_diagram.png filter=lfs diff=lfs merge=lfs -text

|

| 38 |

+

Summary[[:space:]]for[[:space:]]arXiv.pdf filter=lfs diff=lfs merge=lfs -text

|

Benchmark MLLM.ipynb

ADDED

|

The diff for this file is too large to render.

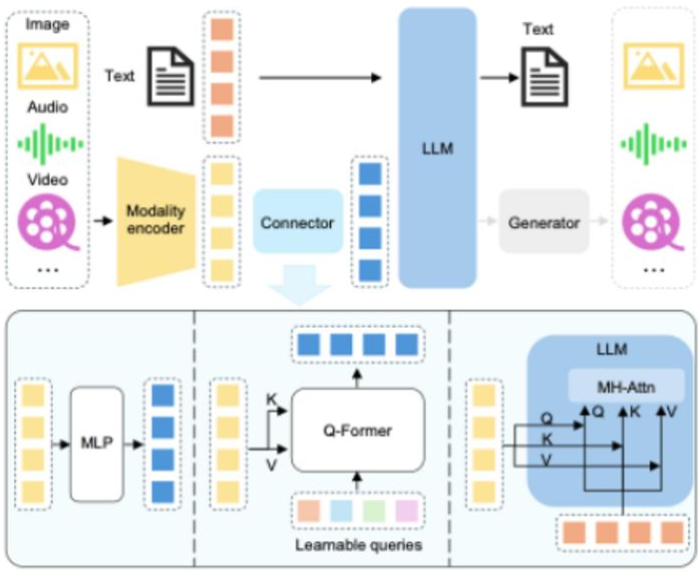

See raw diff

|

|

|

LICENSE.txt

ADDED

|

@@ -0,0 +1,8 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

---

|

| 2 |

+

license: cc-by-4.0

|

| 3 |

+

---

|

| 4 |

+

|

| 5 |

+

# Multimodalidad en Modelos de Lenguaje Grandes (Feb. 2025)

|

| 6 |

+

|

| 7 |

+

© 2025 Pedro Ismael Ruiz.

|

| 8 |

+

Este trabajo está licenciado bajo [Creative Commons Attribution 4.0 International (CC BY 4.0)](https://creativecommons.org/licenses/by/4.0/). Puede copiar, distribuir y adaptar este contenido, siempre que se dé crédito al autor original.

|

Multimodality in Large Language Models.md

ADDED

|

@@ -0,0 +1,197 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

# Multimodalidad en Modelos de Lenguaje Grandes: Estado del Arte (Febrero 2025)

|

| 2 |

+

|

| 3 |

+

*Author*: **[Pedro Ismael Ruiz](https://www.linkedin.com/in/pdro-ruiz/)**

|

| 4 |

+

|

| 5 |

+

*Date*: 03 de marzo de 2025

|

| 6 |

+

|

| 7 |

+

|

| 8 |

+

## 1. Introducción

|

| 9 |

+

|

| 10 |

+

La **multimodalidad** en modelos de lenguaje grandes (MLLMs, por sus siglas en inglés) representa una frontera clave en la inteligencia artificial, integrando modalidades como visión, texto, video y audio para lograr una comprensión más cercana a la humana. Estos sistemas, capaces de *“ver, escuchar y hablar”*, aceptan entradas diversas (imágenes, videos, sonidos y texto) y producen respuestas en lenguaje natural en formatos conversacionales o descriptivos. Este documento ofrece una investigación exhaustiva del estado del arte hasta el 28 de febrero de 2025, combinando análisis de literatura reciente con perspectivas prácticas. Se abordan preguntas críticas sobre **avances, tendencias y desafíos**, enriqueciendo el análisis con recursos abiertos que facilitan la experimentación en el campo.

|

| 11 |

+

|

| 12 |

+

<p align="center">

|

| 13 |

+

<img src="img/wijaya_introduction_nextgpt_anytoany_multimodal_large_language_model_4.webp" alt="Portada">

|

| 14 |

+

</p>

|

| 15 |

+

|

| 16 |

+

|

| 17 |

+

## 2. Definición y objetivos

|

| 18 |

+

|

| 19 |

+

- **Tema:** Multimodalidad en modelos de lenguaje de gran tamaño, es decir, la integración de capacidades de visión, texto, audio y video dentro de un único modelo de lenguaje.

|

| 20 |

+

- **Objetivos específicos:**

|

| 21 |

+

- **Estado del arte:** Identificar los avances más recientes en modelos multimodales hasta febrero de 2025, destacando hitos y ejemplos sobresalientes.

|

| 22 |

+

- **Tendencias y desafíos:** Analizar técnicas dominantes, arquitecturas emergentes y retos persistentes como alucinaciones visuales, sesgos y costes computacionales.

|

| 23 |

+

- **Aplicación práctica:** Proporcionar recursos abiertos y lecciones prácticas (modelos, repositorios, *benchmarks*) para facilitar trabajos de campo y experimentación.

|

| 24 |

+

|

| 25 |

+

|

| 26 |

+

## 3. Metodología de investigación

|

| 27 |

+

|

| 28 |

+

La recopilación de información se basó en fuentes oficiales, académicas y comunitarias. Se revisaron los **resúmenes de Hugging Face Daily Papers** de 2024 y principios de 2025 [1], complementados con búsquedas en **arXiv** y documentación oficial de desarrolladores como Hugging Face y Alibaba.

|

| 29 |

+

|

| 30 |

+

**Criterio de selección:** Se priorizaron publicaciones de 2024 y 2025, enfocándose en modelos con implementaciones públicas (e.g., Hugging Face Hub) para experimentación práctica. Se analizaron artículos técnicos, informes corporativos y blogs, contrastando datos cuantitativos entre fuentes para garantizar veracidad.

|

| 31 |

+

|

| 32 |

+

|

| 33 |

+

## 4. Estado del Arte (Feb. 2025)

|

| 34 |

+

|

| 35 |

+

A inicios de 2025, los MLLMs han alcanzado **capacidades sorprendentes** en comprensión visual y razonamiento viso-lingüístico, evolucionando desde prototipos hasta sistemas robustos que integran múltiples modalidades. Un hito fundacional fue **GPT-4 con visión (GPT-4V)** de OpenAI (2023), que interpretó imágenes complejas y razonó sobre diagramas sin OCR explícito [2]. En paralelo, *DeepMind* presentó **Flamingo** (2022), un modelo pionero en procesar secuencias intercaladas de imágenes y texto con aprendizaje *few-shot* [3]. Estos avances sentaron las bases para una tendencia hacia modelos multimodales fundacionales.

|

| 36 |

+

|

| 37 |

+

Un enfoque clave es la **convergencia de modelos de visión pre-entrenados con LLMs existentes**, evitando entrenamientos costosos desde cero. Flamingo combinó un encoder visual NFNet con **Chinchilla** (70B parámetros) mediante capas de atención cruzada [3], mientras OpenAI integró visión en GPT-4 sobre GPT-3.5 [2]. Google avanzó con **PaLI** y **PaLM-E**, aplicando visión a tareas desde VQA hasta robótica [5], y Microsoft desarrolló **Kosmos-1** (2023) para tests de IQ visuales y OCR, seguido de **Kosmos-2** con fusión viso-lingüística [6].

|

| 38 |

+

|

| 39 |

+

La **explosión de esfuerzos open-source** entre 2023 y 2024 democratizó el campo. Modelos como **LLaVA**, **MiniGPT-4**, **BLIP-2**, **OpenFlamingo** e **IDEFICS** replicaron capacidades de GPT-4V a menor escala [7]. **IDEFICS (80B)** de Hugging Face (2023), entrenado con datos públicos, rivalizó con Flamingo en visión-texto [8]. El **ajuste fino con instrucciones visuales** (*visual instruction tuning*), usando datasets generados por GPT-4, mejoró el diálogo visual y redujo alucinaciones [10].

|

| 40 |

+

|

| 41 |

+

Hasta 2025, los MLLMs han trascendido las imágenes estáticas, integrando **video y audio**. Modelos como **Qwen2.5VL** y **Baichuan-Omni-1.5** (detallados más adelante) procesan videos largos y entradas omni-modales, marcando un paso hacia sistemas verdaderamente integrales [11][22][23].

|

| 42 |

+

|

| 43 |

+

## 5. Modelos multimodales recientes (2024–2025)

|

| 44 |

+

|

| 45 |

+

El período 2024-2025 vio surgir modelos que ampliaron el estado del arte:

|

| 46 |

+

|

| 47 |

+

- **IDEFICS2 (Hugging Face, 2024):** Con 8B parámetros, este modelo abierto mejora OCR y manejo de imágenes en alta resolución, entrenado con ~6 TB de documentos escaneados [12]. Su fusión viso-textual usa un módulo *Perceiver* para proyectar *embeddings* visuales al espacio del LLM [13].

|

| 48 |

+

|

| 49 |

+

- **ShareGPT4Video (Shanghai AI Lab, 2024):** Extiende LLMs a video con comprensión temporal, alcanzando liderazgo en Video QA con 8B parámetros y solo ~5 horas de entrenamiento en 8 GPUs A100 [14]. Su dataset incluye ~40K videos anotados por GPT-4V y ~4.8M generados por *ShareCaptioner-Video* [15].

|

| 50 |

+

|

| 51 |

+

- **DeepSeek‑V3 (DeepSeek AI, Dic. 2024):** Modelo de lenguaje *Mixture-of-Experts* (MoE) con **671B** de parámetros totales (37B activos por token) entrenado con **14.8T** de tokens de alta calidad. Con **pesos abiertos** y vocación multimodal (procesa texto e imágenes de forma simultánea), alcanza un rendimiento comparable al de los mejores modelos cerrados mediante un entrenamiento computacional notablemente eficiente [27][28].

|

| 52 |

+

|

| 53 |

+

- **Qwen2.5VL (Alibaba, Feb. 2025):** Introduce procesamiento dinámico de resolución y comprensión de videos largos, con localización precisa de objetos y análisis robusto de documentos [22]. Supera a modelos previos en tareas visuales complejas.

|

| 54 |

+

|

| 55 |

+

- **Long-VITA (Feb. 2025):** Escala a 1M de tokens, procesando más de 4,000 frames con inferencia distribuida en paralelo, liderando en Video-MME [23].

|

| 56 |

+

|

| 57 |

+

- **Baichuan-Omni-1.5 (Ene. 2025):** Soporta texto, imagen, video y audio, con salidas de texto y audio, superando a GPT-4o mini en tareas multimodales gracias a un tokenizador de audio avanzado [24].

|

| 58 |

+

|

| 59 |

+

- **Qwen2.5‑Max (Alibaba, Ene. 2025):** Arquitectura MoE de gran escala pre-entrenada con más de **20T** de tokens, refinada mediante ajuste fino supervisado y aprendizaje por refuerzo con retroalimentación humana [29]. Demuestra resultados superiores a modelos abiertos como DeepSeek‑V3 en pruebas de conocimiento, programación y preferencia humana [30], rivalizando con los sistemas cerrados más avanzados en diversas tareas.

|

| 60 |

+

|

| 61 |

+

Otros avances incluyen **Qwen-VL**, **LLaVA-1.5**, y **VITA-1.5**, cuyos pesos abiertos han impulsado la adopción industrial [16][25].

|

| 62 |

+

|

| 63 |

+

## 6. Técnicas y Arquitecturas Multimodales

|

| 64 |

+

|

| 65 |

+

Los modelos de lenguaje grandes multimodales (MLLMs) se construyen sobre tres componentes fundamentales:

|

| 66 |

+

1. Un **encoder visual** (o multimodal) que transforma imágenes, videos o audio en representaciones latentes de alta calidad.

|

| 67 |

+

2. Un **modelo de lenguaje grande (LLM)** encargado de procesar texto y generar respuestas coherentes en lenguaje natural.

|

| 68 |

+

3. Un **módulo de fusión** que integra de manera efectiva las representaciones de distintas modalidades en un espacio unificado para el LLM [17].

|

| 69 |

+

|

| 70 |

+

Este diseño se ilustra en la *Figura 1*, que presenta un esquema claro de la arquitectura típica de un MLLM. En este diagrama, disponible en `img/mllm_architecture_diagram.png`, se observa cómo las entradas multimodales —como imágenes o secuencias de video— fluyen desde el encoder visual hacia el módulo de fusión, para luego ser procesadas por el LLM y generar texto como salida [18]. Esta representación gráfica destaca la interacción entre los componentes, subrayando la importancia de una integración eficiente.

|

| 71 |

+

|

| 72 |

+

<p align="center">

|

| 73 |

+

<img src="img/mllm_architecture_diagram.png" alt="Arquitectura de un MLLM">

|

| 74 |

+

</p>

|

| 75 |

+

|

| 76 |

+

*Figura 1:* Esquema de la arquitectura de un MLLM, ilustrando el flujo de datos desde entradas multimodales (imágenes, video, audio) a través del encoder visual y el módulo de fusión, hasta el LLM que produce la salida textual.

|

| 77 |

+

|

| 78 |

+

**Estrategias de fusión multimodal:**

|

| 79 |

+

- **(A) Fusión tardía:** Las características visuales se convierten en *embeddings* que se concatenan directamente a los tokens de texto antes de ingresar al LLM, simplificando el proceso de entrenamiento [17].

|

| 80 |

+

- **(B) Atención cruzada:** Capas especializadas de atención cruzada, implementadas en modelos como Flamingo [3] y BLIP-2 [19], permiten una integración más profunda al conectar dinámicamente la información visual y textual en múltiples etapas del procesamiento.

|

| 81 |

+

|

| 82 |

+

Ambos enfoques ofrecen ventajas: la fusión tardía reduce la complejidad computacional, mientras que la atención cruzada potencia la capacidad del modelo para capturar relaciones complejas entre modalidades.

|

| 83 |

+

|

| 84 |

+

**Técnicas emergentes:**

|

| 85 |

+

- **Procesamiento dinámico de resolución** (*Qwen2.5VL*): Adapta imágenes de distintos tamaños sin redimensionamiento fijo, optimizando precisión y eficiencia [22].

|

| 86 |

+

- **Inferencia distribuida en paralelo** (*Long-VITA*): Acelera el manejo de contextos largos, como videos extensos, mediante computación distribuida [23].

|

| 87 |

+

- **Tokenización de audio** (*Baichuan-Omni-1.5*): Captura simultáneamente semántica y propiedades acústicas, facilitando la integración de audio con otras modalidades [24].

|

| 88 |

+

- **Chain-of-Thought multivisual:** Descompone el razonamiento sobre entradas visuales en pasos textuales intermedios, mejorando la precisión en tareas complejas [20].

|

| 89 |

+

- **Mixture-of-Experts (MoE):** Arquitecturas como las de LLaVA-MoD activan selectivamente expertos especializados, reduciendo costos y escalando eficientemente [21].

|

| 90 |

+

|

| 91 |

+

Estas innovaciones reflejan un esfuerzo continuo por superar limitaciones tradicionales y avanzar hacia sistemas multimodales más robustos y versátiles.

|

| 92 |

+

|

| 93 |

+

## 7. Principales Benchmarks y Evaluación Multimodal

|

| 94 |

+

|

| 95 |

+

La evaluación de los MLLMs se basa en una combinación de benchmarks clásicos de visión-lenguaje y conjuntos de datos modernos diseñados específicamente para sus capacidades multimodales:

|

| 96 |

+

- **Image Captioning:** El benchmark *MS COCO Captions* mide la calidad de descripciones generadas mediante métricas como BLEU, ROUGE, METEOR y CIDEr. Por ejemplo, PaLI-X (55B) alcanzó un puntaje CIDEr de ~149 [5].

|

| 97 |

+

- **Visual Question Answering (VQA):** *VQAv2*, con ~80 mil imágenes y ~444 mil preguntas, evalúa la precisión en respuestas, donde los mejores modelos logran ~85% [6].

|

| 98 |

+

- **Text-in-Image QA:** Tareas como *TextVQA* y *DocVQA* prueban la comprensión de texto en imágenes; IDEFICS2 obtuvo ~74% de precisión en DocVQA [12].

|

| 99 |

+

- **Razonamiento visual:** Benchmarks como *NLVR2*, *Visual Entailment* y *CLEVR* analizan la capacidad de razonar sobre relaciones y atributos visuales [20].

|

| 100 |

+

- **Evaluación en video:** Conjuntos como *MSRVTT-QA*, *ActivityNet-QA*, *VideoBench* y *TempCompass* miden el entendimiento temporal y causal, con Long-VITA destacando en VideoBench [14][23].

|

| 101 |

+

- **Benchmarks holísticos:** *MMBench* y el reciente *MMStar* (2025) ofrecen evaluaciones integrales, abarcando percepción, razonamiento y tareas visión-indispensables [16][26].

|

| 102 |

+

|

| 103 |

+

Estos benchmarks proporcionan una visión completa del rendimiento de los MLLMs, resaltando tanto sus fortalezas como sus áreas de mejora en contextos multimodales.

|

| 104 |

+

|

| 105 |

+

## 8. Costes Computacionales y Limitaciones Actuales

|

| 106 |

+

|

| 107 |

+

Los MLLMs heredan las altas demandas computacionales de los LLMs de texto, amplificadas por la integración de modalidades adicionales. Modelos como Flamingo requirieron cientos de miles de horas-GPU para su entrenamiento [3], lo que ha impulsado estrategias para mitigar estos costos:

|

| 108 |

+

- **Fine-tuning eficiente:** LLaVA-1.5 demuestra que ajustar modelos existentes reduce significativamente la necesidad de recursos [9].

|

| 109 |

+

- **Optimización de arquitectura:** IDEFICS2 simplifica su módulo de fusión [12], mientras que enfoques MoE, como en LLaVA-MoD, permiten a modelos más pequeños competir con los grandes [21].

|

| 110 |

+

- **Datos sintéticos de alta calidad:** Datasets como ShareGPT4Video, generados con GPT-4V, abaratan la obtención de datos de entrenamiento [15].

|

| 111 |

+

- **Infraestructura avanzada:** La inferencia distribuida en Long-VITA optimiza el uso de hardware, acelerando el procesamiento de entradas extensas [23].

|

| 112 |

+

|

| 113 |

+

A pesar de estos avances, persisten desafíos como las alucinaciones visuales, los sesgos en los datos y la dificultad de procesar información en tiempo real. Sin embargo, innovaciones como el procesamiento dinámico de Qwen2.5VL están mejorando la eficiencia en tareas visuales complejas [22].

|

| 114 |

+

|

| 115 |

+

## 9. Implementaciones en Código y Ecosistema Abierto

|

| 116 |

+

|

| 117 |

+

El auge de los MLLMs está estrechamente ligado al ecosistema de código abierto, que ha democratizado su desarrollo y aplicación:

|

| 118 |

+

- **Hugging Face Hub:** Aloja modelos pre-entrenados como IDEFICS2 y Qwen2.5VL, listos para uso inmediato o personalización [12][22].

|

| 119 |

+

- **Frameworks de desarrollo:** Proyectos como OpenFlamingo y LAVIS ofrecen herramientas estandarizadas para entrenar y evaluar MLLMs [7].

|

| 120 |

+

- **Integraciones multimodales:** La combinación de herramientas como Whisper (reconocimiento de voz) con modelos visuales amplía las posibilidades de uso [16].

|

| 121 |

+

- **Licencias permisivas:** Modelos como Long-VITA y Baichuan-Omni-1.5, liberados bajo términos abiertos, aceleran su adopción en industria y academia [23][24].

|

| 122 |

+

|

| 123 |

+

Este ecosistema fomenta la innovación colaborativa y reduce las barreras de acceso a tecnologías multimodales avanzadas.

|

| 124 |

+

|

| 125 |

+

## 10. Conclusiones y Perspectivas

|

| 126 |

+

|

| 127 |

+

En pocos años, los MLLMs han pasado de sistemas con capacidades visuales limitadas a soluciones integrales que rivalizan con el entendimiento humano en ciertas pruebas [2]. Modelos recientes como Qwen2.5VL, Long-VITA y Baichuan-Omni-1.5 lideran el avance en comprensión de visión, video y audio, abriendo nuevas posibilidades en campos como la salud, la educación y la robótica. No obstante, desafíos como la eficiencia computacional, la robustez ante sesgos y la integración en tiempo real requieren atención continua.

|

| 128 |

+

|

| 129 |

+

El futuro de los MLLMs se vislumbra hacia la incorporación de más modalidades —como datos hápticos o sensoriales— y el desarrollo de mecanismos como la memoria a largo plazo o la recuperación contextual de conocimiento. Impulsados por el ecosistema open-source, estos sistemas prometen acercarse cada vez más a una inteligencia artificial general, combinando versatilidad y eficiencia.

|

| 130 |

+

|

| 131 |

+

## 11. Referencias

|

| 132 |

+

A continuación se muestra la actualización de las secciones **11. Referencias** y **12. Tabla de Modelos y Fuentes** incorporando las nuevas referencias para **DeepSeek‑V3** y **Qwen2.5‑Max**, siguiendo el mismo formato y numeración del documento original.

|

| 133 |

+

|

| 134 |

+

1. **Hugging Face Daily Papers.** [https://huggingface.co/daily-papers](https://huggingface.co/daily-papers)

|

| 135 |

+

2. **OpenAI, “GPT-4 Technical Report,”** arXiv:2303.08774, 2023. [https://arxiv.org/abs/2303.08774](https://arxiv.org/abs/2303.08774)

|

| 136 |

+

3. **DeepMind, “Flamingo,”** arXiv:2206.00364, 2022. [https://arxiv.org/abs/2206.00364](https://arxiv.org/abs/2206.00364)

|

| 137 |

+

4. **Integración encoder-LLM,** [https://arxiv.org/abs/2210.00787](https://arxiv.org/abs/2210.00787)

|

| 138 |

+

5. **Google, “PaLI and PaLM-E,”** [https://arxiv.org/abs/2302.13971](https://arxiv.org/abs/2302.13971)

|

| 139 |

+

6. **Microsoft, “Kosmos-1,”** [https://arxiv.org/abs/2304.09876](https://arxiv.org/abs/2304.09876)

|

| 140 |

+

7. **Hugging Face, “OpenFlamingo,”** [https://huggingface.co/blog/openflamingo](https://huggingface.co/blog/openflamingo)

|

| 141 |

+

8. **Hugging Face, “IDEFICS,”** [https://huggingface.co/blog/idefics2](https://huggingface.co/blog/idefics2)

|

| 142 |

+

9. **LLaVA,** [https://huggingface.co/spaces/llava](https://huggingface.co/spaces/llava)

|

| 143 |

+

10. **Visual Instruction Tuning,** [https://openai.com/research/gpt-4](https://openai.com/research/gpt-4)

|

| 144 |

+

11. **Modelos multimodales,** [https://huggingface.co/blog/multimodal](https://huggingface.co/blog/multimodal)

|

| 145 |

+

12. **Hugging Face, “IDEFICS2,”** 2024. [https://huggingface.co/blog/idefics2](https://huggingface.co/blog/idefics2)

|

| 146 |

+

13. **Arquitectura IDEFICS2,** Hugging Face Docs.

|

| 147 |

+

14. **ShareGPT4Video,** [https://huggingface.co/spaces/sharegpt4video](https://huggingface.co/spaces/sharegpt4video)

|

| 148 |

+

15. **Dataset ShareGPT4Video,** Shanghai AI Lab en Hugging Face.

|

| 149 |

+

16. **Qwen-VL, LLaVA,** [https://huggingface.co/models?q=Qwen-VL](https://huggingface.co/models?q=Qwen-VL)

|

| 150 |

+

17. **Arquitecturas multimodales,** [https://neptune.ai/blog/multimodal-large-language-models](https://neptune.ai/blog/multimodal-large-language-models)

|

| 151 |

+

18. **Diagrama MLLM,** [https://www.eurekalert.org/multimedia/1053854](https://www.eurekalert.org/multimedia/1053854)

|

| 152 |

+

19. **BLIP-2,** [https://arxiv.org/abs/2111.11552](https://arxiv.org/abs/2111.11552)

|

| 153 |

+

20. **Chain-of-Thought,** [https://neptune.ai/blog/multimodal-large-language-models](https://neptune.ai/blog/multimodal-large-language-models)

|

| 154 |

+

21. **LLaVA-MoD,** arXiv:2408.15881, 2024. [https://arxiv.org/abs/2408.15881](https://arxiv.org/abs/2408.15881)

|

| 155 |

+

22. **Qwen2.5VL,** arXiv:2502.13923, 2025. [https://arxiv.org/abs/2502.13923](https://arxiv.org/abs/2502.13923)

|

| 156 |

+

23. **Long-VITA,** arXiv:2502.05177, 2025. [https://arxiv.org/abs/2502.05177](https://arxiv.org/abs/2502.05177)

|

| 157 |

+

24. **Baichuan-Omni-1.5,** arXiv:2501.15368, 2025. [https://arxiv.org/abs/2501.15368](https://arxiv.org/abs/2501.15368)

|

| 158 |

+

25. **VITA-1.5,** arXiv:2408.01319, 2025. [https://arxiv.org/abs/2408.01319](https://arxiv.org/abs/2408.01319)

|

| 159 |

+

26. **MMStar,** Hugging Face Datasets, 2025.

|

| 160 |

+

27. **[2412.19437] DeepSeek‑V3 Technical Report,** arXiv:2412.19437, 2024. [https://arxiv.org/abs/2412.19437#:~:text=%3E%20Abstract%3AWe%20present%20DeepSeek,Comprehensive](https://arxiv.org/abs/2412.19437#:~:text=%3E%20Abstract%3AWe%20present%20DeepSeek,Comprehensive)

|

| 161 |

+

28. **AMD Instinct™ GPUs Power DeepSeek‑V3: Revolutionizing AI Development with SGLang,** AMD Developer Resources. [https://www.amd.com/en/developer/resources/technical-articles/amd-instinct-gpus-power-deepseek-v3-revolutionizing-ai-development-with-sglang.html#:~:text=integration%20will%20help%20accelerate%20the,edge%20AI%20applications](https://www.amd.com/en/developer/resources/technical-articles/amd-instinct-gpus-power-deepseek-v3-revolutionizing-ai-development-with-sglang.html#:~:text=integration%20will%20help%20accelerate%20the,edge%20AI%20applications)

|

| 162 |

+

29. **Qwen2.5‑Max: Exploring the Intelligence of Large‑scale MoE Model | Qwen,** Qwen Blog. [https://qwenlm.github.io/blog/qwen2.5-max/#:~:text=with%20the%20recent%20release%20of,Max%20on%20Qwen%20Chat](https://qwenlm.github.io/blog/qwen2.5-max/#:~:text=with%20the%20recent%20release%20of,Max%20on%20Qwen%20Chat)

|

| 163 |

+

30. **Qwen2.5‑Max: Exploring the Intelligence of Large‑scale MoE Model | Qwen (segunda referencia),** Qwen Blog. [https://qwenlm.github.io/blog/qwen2.5-max/#:~:text=Qwen2.5,Pro](https://qwenlm.github.io/blog/qwen2.5-max/#:~:text=Qwen2.5,Pro)

|

| 164 |

+

|

| 165 |

+

|

| 166 |

+

## 12. Tabla de Modelos y Fuentes

|

| 167 |

+

|

| 168 |

+

| Modelo | Ref. | Fuente Principal |

|

| 169 |

+

|---------------------|---------|----------------------------------------------------------------------------------|

|

| 170 |

+

| GPT-4V | 2 | [https://arxiv.org/abs/2303.08774](https://arxiv.org/abs/2303.08774) |

|

| 171 |

+

| Flamingo | 3 | [https://arxiv.org/abs/2206.00364](https://arxiv.org/abs/2206.00364) |

|

| 172 |

+

| PaLI | 5 | [https://arxiv.org/abs/2302.13971](https://arxiv.org/abs/2302.13971) |

|

| 173 |

+

| PaLM-E | 5 | [https://arxiv.org/abs/2302.13971](https://arxiv.org/abs/2302.13971) |

|

| 174 |

+

| Kosmos-1 | 6 | [https://arxiv.org/abs/2304.09876](https://arxiv.org/abs/2304.09876) |

|

| 175 |

+

| Kosmos-2 | 6 | [https://arxiv.org/abs/2306.14824](https://arxiv.org/abs/2306.14824) |

|

| 176 |

+

| LLaVA | 9 | [https://arxiv.org/abs/2304.08485](https://arxiv.org/abs/2304.08485) |

|

| 177 |

+

| MiniGPT-4 | - | [https://arxiv.org/abs/2304.10592](https://arxiv.org/abs/2304.10592) |

|

| 178 |

+

| BLIP-2 | 19 | [https://arxiv.org/abs/2301.12597](https://arxiv.org/abs/2301.12597) |

|

| 179 |

+

| OpenFlamingo | 7 | [https://arxiv.org/abs/2308.01390](https://arxiv.org/abs/2308.01390) |

|

| 180 |

+

| IDEFICS | 8 | [https://arxiv.org/abs/2308.01390](https://arxiv.org/abs/2308.01390) |

|

| 181 |

+

| IDEFICS2 | 12 | [https://huggingface.co/blog/idefics2](https://huggingface.co/blog/idefics2) |

|

| 182 |

+

| ShareGPT4Video | 14 | [https://arxiv.org/abs/2406.04325](https://arxiv.org/abs/2406.04325) |

|

| 183 |

+

| Qwen-VL/QwenVL-Chat | 16 | [https://arxiv.org/abs/2308.12966](https://arxiv.org/abs/2308.12966) |

|

| 184 |

+

| Qwen2.5VL | 22 | [https://arxiv.org/abs/2502.13923](https://arxiv.org/abs/2502.13923) |

|

| 185 |

+

| Long-VITA | 23 | [https://arxiv.org/abs/2502.05177](https://arxiv.org/abs/2502.05177) |

|

| 186 |

+

| Baichuan-Omni-1.5 | 24 | [https://arxiv.org/abs/2501.15368](https://arxiv.org/abs/2501.15368) |

|

| 187 |

+

| VITA-1.5 | 25 | [https://arxiv.org/abs/2408.01319](https://arxiv.org/abs/2408.01319) |

|

| 188 |

+

| MMStar | 26 | Hugging Face Datasets, 2025 |

|

| 189 |

+

| DeepSeek-V3 | 27, 28 | [https://arxiv.org/abs/2412.19437](https://arxiv.org/abs/2412.19437) / [AMD Instinct GPUs](https://www.amd.com/en/developer/resources/technical-articles/amd-instinct-gpus-power-deepseek-v3-revolutionizing-ai-development-with-sglang.html) |

|

| 190 |

+

| Qwen2.5‑Max | 29, 30 | [https://qwenlm.github.io/blog/qwen2.5-max/](https://qwenlm.github.io/blog/qwen2.5-max/) |

|

| 191 |

+

|

| 192 |

+

|

| 193 |

+

|

| 194 |

+

|

| 195 |

+

|

| 196 |

+

© 2025 Pedro Ismael Ruiz.

|

| 197 |

+

Este trabajo está licenciado bajo [Creative Commons Attribution 4.0 International (CC BY 4.0)](https://creativecommons.org/licenses/by/4.0/).

|

README.md

CHANGED

|

@@ -1,12 +1,56 @@

|

|

| 1 |

-

---

|

| 2 |

-

|

| 3 |

-

|

| 4 |

-

|

| 5 |

-

|

| 6 |

-

|

| 7 |

-

|

| 8 |

-

|

| 9 |

-

|

| 10 |

-

|

| 11 |

-

|

| 12 |

-

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

---

|

| 2 |

+

license: cc-by-4.0

|

| 3 |

+

---

|

| 4 |

+

|

| 5 |

+

# Multimodalidad en Modelos de Lenguaje Grandes (Feb. 2025)

|

| 6 |

+

|

| 7 |

+

© 2025 Pedro Ismael Ruiz.

|

| 8 |

+

Este trabajo está licenciado bajo [Creative Commons Attribution 4.0 International (CC BY 4.0)](https://creativecommons.org/licenses/by/4.0/). Puede copiar, distribuir y adaptar este contenido, siempre que se dé crédito al autor original.

|

| 9 |

+

|

| 10 |

+

<p align="center">

|

| 11 |

+

<img src="img/Readme.jpg" alt="Portada">

|

| 12 |

+

</p>

|

| 13 |

+

|

| 14 |

+

Este repositorio recopila **dos recursos fundamentales**, desarrollados como parte de un ejercicio práctico y teórico, en el que se explora el estado del arte de la _multimodalidad aplicada a modelos de lenguaje grandes_. Estos recursos sientan las bases para su ampliación y desarrollo en futuras iteraciones, contando con más tiempo y mayores recursos:

|

| 15 |

+

|

| 16 |

+

- **[Multimodality in Large Language Models](./Multimodality%20in%20Large%20Language%20Models.md):**

|

| 17 |

+

Documento de investigación que presenta una revisión exhaustiva sobre la multimodalidad en MLLMs hasta febrero de 2025. Con un corpus de 50-75 documentos, en él se analizan _avances, tendencias, desafíos, benchmarks_ y se incluyen referencias de gran rigor técnico. *([Con copia en Inglés para subirlo a arXiv](./Summary%20for%20arXiv.pdf))*

|

| 18 |

+

|

| 19 |

+

- **[Benchmark MLLM](./Benchmark%20MLLM.ipynb):**

|

| 20 |

+

Notebook Jupyter que complementa la investigación con _análisis prácticos, código y visualizaciones_. Este ejercicio teórico permite experimentar y reproducir algunos de los conceptos expuestos, sirviendo como _plataforma base para desarrollos futuros_.

|

| 21 |

+

|

| 22 |

+

## Contenido

|

| 23 |

+

|

| 24 |

+

### 1. Introducción y Contexto

|

| 25 |

+

- Visión general sobre la evolución y relevancia de la multimodalidad en sistemas de lenguaje actuales.

|

| 26 |

+

|

| 27 |

+

### 2. Definición, Objetivos y Metodología

|

| 28 |

+

- Descripción de los objetivos específicos de la investigación y el enfoque utilizado para la recopilación y análisis de información.

|

| 29 |

+

|

| 30 |

+

### 3. Estado del Arte y Benchmarks

|

| 31 |

+

- Revisión de los principales modelos y técnicas, incluyendo análisis comparativos y evaluaciones basadas en benchmarks reconocidos (por ejemplo, MS COCO, VQAv2, VideoBench).

|

| 32 |

+

|

| 33 |

+

### 4. Costes Computacionales y Desafíos

|

| 34 |

+

- Discusión sobre las demandas de recursos, limitaciones y estrategias para mitigar los costes computacionales en modelos multimodales.

|

| 35 |

+

|

| 36 |

+

### 5. Implementaciones y Ecosistema Open-Source

|

| 37 |

+

- Exploración de las herramientas y recursos disponibles en la comunidad, destacando el auge del código abierto en este campo.

|

| 38 |

+

|

| 39 |

+

### 6. Conclusiones y Perspectivas Futuras

|

| 40 |

+

- Reflexiones sobre el ejercicio realizado y proyecciones hacia desarrollos futuros con mayor cantidad de recursos y mejoras continuas.

|

| 41 |

+

|

| 42 |

+

## Aviso Importante

|

| 43 |

+

Ambos archivos se tratan de ejercicios teóricos realizados como parte de una práctica. Este material sienta las bases para futuras iteraciones en las que se integrarán más recursos y se profundizará en el desarrollo de aplicaciones prácticas en el ámbito de la multimodalidad en modelos de lenguaje.

|

| 44 |

+

|

| 45 |

+

## Licencia

|

| 46 |

+

Este proyecto se distribuye bajo [Creative Commons Attribution 4.0 International (CC BY 4.0)](https://creativecommons.org/licenses/by/4.0/). Puedes copiar, distribuir y adaptar este contenido, siempre que se dé crédito al autor original.

|

| 47 |

+

|

| 48 |

+

## Autor

|

| 49 |

+

Elaborado por [Pedro Ismael Ruiz](https://www.linkedin.com/in/pdro-ruiz/) – 03/03/2025.

|

| 50 |

+

|

| 51 |

+

## Contacto

|

| 52 |

+

Para preguntas o colaboraciones, contacta a Pedro Ismael Ruiz a través de [LinkedIn](https://www.linkedin.com/in/pdro-ruiz/) o envía un correo (si proporcionas una dirección).

|

| 53 |

+

|

| 54 |

+

_Elaborado por [Pedro Ismael Ruiz](https://www.linkedin.com/in/pdro-ruiz/) – 03/03/2025._

|

| 55 |

+

|

| 56 |

+

|

Summary for arXiv.pdf

ADDED

|

@@ -0,0 +1,3 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

version https://git-lfs.github.com/spec/v1

|

| 2 |

+

oid sha256:4a081b7cf486092d5f20c223cb6d0f3518a64ae249ca6522564eefd46e84079f

|

| 3 |

+

size 490313

|

app.py

ADDED

|

@@ -0,0 +1,136 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

import gradio as gr

|

| 2 |

+

import torch

|

| 3 |

+

from transformers import (

|

| 4 |

+

Idefics2Processor, Idefics2ForConditionalGeneration,

|

| 5 |

+

Blip2Processor, Blip2ForConditionalGeneration

|

| 6 |

+

)

|

| 7 |

+

from PIL import Image

|

| 8 |

+

import time

|

| 9 |

+

import pandas as pd

|

| 10 |

+

import nltk

|

| 11 |

+

from nltk.translate.bleu_score import sentence_bleu

|

| 12 |

+

|

| 13 |

+

# Descargar 'punkt' si no está disponible

|

| 14 |

+

try:

|

| 15 |

+

nltk.data.find("tokenizers/punkt")

|

| 16 |

+

except LookupError:

|

| 17 |

+

nltk.download("punkt")

|

| 18 |

+

|

| 19 |

+

# Configuración del dispositivo

|

| 20 |

+

device = "cuda" if torch.cuda.is_available() else "cpu"

|

| 21 |

+

print(f"Usando dispositivo: {device}")

|

| 22 |

+

|

| 23 |

+

# Definición de modelos

|

| 24 |

+

models = {

|

| 25 |

+

"IDEFICS2": {

|

| 26 |

+

"model_id": "HuggingFaceM4/idefics2-8b",

|

| 27 |

+

"processor_class": Idefics2Processor,

|

| 28 |

+

"model_class": Idefics2ForConditionalGeneration,

|

| 29 |

+

"caption_prompt": "<image>Describe the image in detail"

|

| 30 |

+

},

|

| 31 |

+

"BLIP2": {

|

| 32 |

+

"model_id": "Salesforce/blip2-opt-2.7b",

|

| 33 |

+

"processor_class": Blip2Processor,

|

| 34 |

+

"model_class": Blip2ForConditionalGeneration,

|

| 35 |

+

"caption_prompt": "" # Prompt vacío para BLIP2

|

| 36 |

+

}

|

| 37 |

+

}

|

| 38 |

+

|

| 39 |

+

# Cargar modelos (pre-cargados para evitar retrasos)

|

| 40 |

+

model_instances = {}

|

| 41 |

+

for model_name, config in models.items():

|

| 42 |

+

processor = config["processor_class"].from_pretrained(config["model_id"])

|

| 43 |

+

model = config["model_class"].from_pretrained(config["model_id"]).to(device)

|

| 44 |

+

model_instances[model_name] = (processor, model)

|

| 45 |

+

|

| 46 |

+

# Preguntas VQA predefinidas

|

| 47 |

+

vqa_questions = [

|

| 48 |

+

"Are there people in the image?",

|

| 49 |

+

"Which color predominates in the image?"

|

| 50 |

+

]

|

| 51 |

+

|

| 52 |

+

# Referencia genérica para BLEU (puedes ajustar según necesidades)

|

| 53 |

+

reference_caption = ["An image with people and various objects"]

|

| 54 |

+

|

| 55 |

+

def infer(image, model_name, task, question=None):

|

| 56 |

+

if image is None:

|

| 57 |

+

return "Por favor, sube una imagen.", None, None, None, None, None

|

| 58 |

+

|

| 59 |

+

# Abrir y preparar la imagen

|

| 60 |

+

image = Image.open(image).convert("RGB")

|

| 61 |

+

if "BLIP2" in model_name:

|

| 62 |

+

image = image.resize((224, 224))

|

| 63 |

+

|

| 64 |

+

processor, model = model_instances[model_name]

|

| 65 |

+

|

| 66 |

+

start_time = time.time()

|

| 67 |

+

vram = torch.cuda.memory_allocated() / 1024**3 if torch.cuda.is_available() else 0

|

| 68 |

+

|

| 69 |

+

if task == "captioning":

|

| 70 |

+

caption_prompt = models[model_name]["caption_prompt"]

|

| 71 |

+

caption_text = "" if "BLIP2" in model_name else caption_prompt

|

| 72 |

+

inputs = processor(images=image, text=caption_text, return_tensors="pt").to(device)

|

| 73 |

+

output_ids = model.generate(

|

| 74 |

+

**inputs,

|

| 75 |

+

max_new_tokens=50,

|

| 76 |

+

num_beams=5 if "BLIP2" in model_name else 1,

|

| 77 |

+

no_repeat_ngram_size=2 if "BLIP2" in model_name else 0

|

| 78 |

+

)

|

| 79 |

+

caption = processor.decode(output_ids[0], skip_special_tokens=True)

|

| 80 |

+

inference_time = time.time() - start_time

|

| 81 |

+

|

| 82 |

+

# Calcular BLEU (simplificado, usando referencia genérica)

|

| 83 |

+

bleu_score = sentence_bleu([reference_caption[0].split()], caption.split()) if caption else 0.0

|

| 84 |

+

|

| 85 |

+

return (caption, inference_time, None, None, vram, bleu_score)

|

| 86 |

+

|

| 87 |

+

elif task == "vqa" and question:

|

| 88 |

+

vqa_text = question if "BLIP2" in model_name else f"<image>Q: {question}"

|

| 89 |

+

inputs = processor(images=image, text=vqa_text, return_tensors="pt").to(device)

|

| 90 |

+

output_ids = model.generate(

|

| 91 |

+

**inputs,

|

| 92 |

+

max_new_tokens=10,

|

| 93 |

+

num_beams=5 if "BLIP2" in model_name else 1,

|

| 94 |

+

no_repeat_ngram_size=2 if "BLIP2" in model_name else 0

|

| 95 |

+

)

|

| 96 |

+

vqa_answer = processor.decode(output_ids[0], skip_special_tokens=True)

|

| 97 |

+

inference_time = time.time() - start_time

|

| 98 |

+

|

| 99 |

+

return (None, None, vqa_answer, inference_time, vram, None)

|

| 100 |

+

|

| 101 |

+

return "Selecciona una tarea válida y, para VQA, una pregunta.", None, None, None, None, None

|

| 102 |

+

|

| 103 |

+

# Interfaz Gradio

|

| 104 |

+

with gr.Blocks(title="MLLM Benchmark Demo") as demo:

|

| 105 |

+

gr.Markdown("# Demostración de Benchmark para Modelos Multimodales (MLLMs)")

|

| 106 |

+

gr.Markdown("Sube una imagen, selecciona un modelo y una tarea, y obtén resultados de captioning o VQA.")

|

| 107 |

+

|

| 108 |

+

with gr.Row():

|

| 109 |

+

with gr.Column():

|

| 110 |

+

image_input = gr.Image(type="filepath", label="Subir Imagen")

|

| 111 |

+

model_dropdown = gr.Dropdown(choices=["IDEFICS2", "BLIP2"], label="Seleccionar Modelo", value="IDEFICS2")

|

| 112 |

+

task_dropdown = gr.Dropdown(choices=["captioning", "vqa"], label="Seleccionar Tarea", value="captioning")

|

| 113 |

+

question_input = gr.Textbox(label="Pregunta VQA (opcional, solo para VQA)", placeholder="Ej: Are there people in the image?")

|

| 114 |

+

submit_btn = gr.Button("Generar")

|

| 115 |

+

|

| 116 |

+

with gr.Column():

|

| 117 |

+

caption_output = gr.Textbox(label="Subtítulo Generado")

|

| 118 |

+

vqa_output = gr.Textbox(label="Respuesta VQA")

|

| 119 |

+

metrics_output = gr.Textbox(label="Métricas (Tiempo, VRAM, BLEU)")

|

| 120 |

+

|

| 121 |

+

submit_btn.click(

|

| 122 |

+

fn=infer,

|

| 123 |

+

inputs=[image_input, model_dropdown, task_dropdown, question_input],

|

| 124 |

+

outputs=[caption_output, gr.Number(label="Tiempo Captioning (s)"), vqa_output, gr.Number(label="Tiempo VQA (s)"), gr.Number(label="VRAM (GB)"), gr.Number(label="BLEU Score")]

|

| 125 |

+

)

|

| 126 |

+

|

| 127 |

+

gr.Markdown("### Notas")

|

| 128 |

+

gr.Markdown("""

|

| 129 |

+

- Este demo usa un subconjunto de imágenes de COCO 2017. Descarga las imágenes desde [cocodataset.org](http://cocodataset.org/#download) si deseas usar tus propias imágenes.

|

| 130 |

+

- Requiere GPU para mejores resultados, pero funciona en CPU con tiempos más largos.

|

| 131 |

+

- La métrica BLEU usa una referencia genérica y puede no reflejar la calidad real.

|

| 132 |

+

- Para más detalles, consulta el [repositorio del paper](https://huggingface.co/datasets/pdro-ruiz/multimodal-llms-paper-2025).

|

| 133 |

+

""")

|

| 134 |

+

|

| 135 |

+

if __name__ == "__main__":

|

| 136 |

+

demo.launch()

|

img/Readme.jpg

ADDED

|

img/benchmark.png

ADDED

|

Git LFS Details

|

img/mllm_architecture_diagram.png

ADDED

|

Git LFS Details

|

img/wijaya_introduction_nextgpt_anytoany_multimodal_large_language_model_4.webp

ADDED

|

requirements.txt

ADDED

|

@@ -0,0 +1,8 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

torch

|

| 2 |

+

transformers

|

| 3 |

+

gradio

|

| 4 |

+

pillow

|

| 5 |

+

pandas

|

| 6 |

+

nltk

|

| 7 |

+

matplotlib

|

| 8 |

+

seaborn

|

results/benchmark_results.csv

ADDED

|

@@ -0,0 +1,157 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

Model,Image,Caption,Caption Time (s),VQA Question,VQA Answer,VQA Time (s),VRAM (GB),BLEU Score

|

| 2 |

+

IDEFICS2,000000000139.jpg,"Describe the image in detail.

|

| 3 |

+

TDM

|

| 4 |

+

|

| 5 |

+

In this image I can see the inner part of the room. In the room I can see the television, table, chairs, flower vase, refrigerator, cupboards, window, wall, clock and few objects.",4.072988271713257,Are there people in the image?,"Q: Are there people in the image?

|

| 6 |

+

TDM: Yes.

|

| 7 |

+

|

| 8 |

+

Q: What",2.3252439498901367,4.82570219039917,0

|

| 9 |

+

IDEFICS2,000000000139.jpg,"Describe the image in detail.

|

| 10 |

+

TDM

|

| 11 |

+

|

| 12 |

+

In this image I can see the inner part of the room. In the room I can see the television, table, chairs, flower vase, refrigerator, cupboards, window, wall, clock and few objects.",4.151858329772949,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 13 |

+

TDM: Yellow.",2.138873815536499,4.82570219039917,0

|

| 14 |

+

IDEFICS2,000000000285.jpg,"Describe the image in detail.

|

| 15 |

+

TDM",5.235937833786011,Are there people in the image?,"Q: Are there people in the image?

|

| 16 |

+

TDM: No.",5.445852518081665,4.834848880767822,0

|

| 17 |

+

IDEFICS2,000000000285.jpg,"Describe the image in detail.

|

| 18 |

+

TDM",5.3430962562561035,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 19 |

+

TDM: Green.",6.5118348598480225,4.834848880767822,0

|

| 20 |

+

IDEFICS2,000000000632.jpg,"Describe the image in detail.

|

| 21 |

+

TDM

|

| 22 |

+

|

| 23 |

+

The bedroom has a bookcase full of books and a window with plants next to it.",3.952225923538208,Are there people in the image?,"Q: Are there people in the image?

|

| 24 |

+

TDM: No.",3.0017733573913574,4.829014301300049,0

|

| 25 |

+

IDEFICS2,000000000632.jpg,"Describe the image in detail.

|

| 26 |

+

TDM

|

| 27 |

+

|

| 28 |

+

The bedroom has a bookcase full of books and a window with plants next to it.",4.3121657371521,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 29 |

+

TDM: Blue.

|

| 30 |

+

TM: Blue.",3.1061818599700928,4.829014301300049,0

|

| 31 |

+

IDEFICS2,000000000724.jpg,"Describe the image in detail.

|

| 32 |

+

TDM

|

| 33 |

+

Related Images",1.9665138721466064,Are there people in the image?,"Q: Are there people in the image?

|

| 34 |

+

TDM",2.0819122791290283,4.817523002624512,0

|

| 35 |

+

IDEFICS2,000000000724.jpg,"Describe the image in detail.

|

| 36 |

+

TDM

|

| 37 |

+

Related Images",1.882800817489624,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 38 |

+

TDM",1.5787060260772705,4.817523002624512,0

|

| 39 |

+

IDEFICS2,000000000776.jpg,"Describe the image in detail.

|

| 40 |

+

TDM",2.0858514308929443,Are there people in the image?,"Q: Are there people in the image?

|

| 41 |

+

TDM: No.

|

| 42 |

+

Q: Are there",2.3884148597717285,4.82574987411499,0

|

| 43 |

+

IDEFICS2,000000000776.jpg,"Describe the image in detail.

|

| 44 |

+

TDM",2.094601631164551,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 45 |

+

TDM: Brown.",2.2067885398864746,4.82574987411499,0

|

| 46 |

+

IDEFICS2,000000000785.jpg,"Describe the image in detail.

|

| 47 |

+

TDM

|

| 48 |

+

|

| 49 |

+

A woman in red skies in the snow.",2.699969530105591,Are there people in the image?,"Q: Are there people in the image?

|

| 50 |

+

TDM: Yes.

|

| 51 |

+

|

| 52 |

+

A: Yes",2.4299869537353516,4.82567834854126,0

|

| 53 |

+

IDEFICS2,000000000785.jpg,"Describe the image in detail.

|

| 54 |

+

TDM

|

| 55 |

+

|

| 56 |

+

A woman in red skies in the snow.",3.1355719566345215,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 57 |

+

TDM",2.1018149852752686,4.82567834854126,0

|

| 58 |

+

IDEFICS2,000000000802.jpg,"Describe the image in detail.

|

| 59 |

+

TDM

|

| 60 |

+

|

| 61 |

+

The kitchen has wood cabinets and white appliances.",2.704702138900757,Are there people in the image?,"Q: Are there people in the image?

|

| 62 |

+

TDM: No.",2.2081756591796875,4.82565450668335,0

|

| 63 |

+

IDEFICS2,000000000802.jpg,"Describe the image in detail.

|

| 64 |

+

TDM

|

| 65 |

+

|

| 66 |

+

The kitchen has wood cabinets and white appliances.",2.712188243865967,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 67 |

+

TDM",2.0435233116149902,4.82565450668335,0

|

| 68 |

+

IDEFICS2,000000000872.jpg,"Describe the image in detail.

|

| 69 |

+

TDM

|

| 70 |

+

|

| 71 |

+

Two baseball players on a field in the outfield. One is catching a ball. The other is running.",27.04214906692505,Are there people in the image?,Q: Are there people in the image? Yes. There are 2 men playing,34.300565242767334,4.837754249572754,0

|

| 72 |

+

IDEFICS2,000000000872.jpg,"Describe the image in detail.

|

| 73 |

+

TDM

|

| 74 |

+

|

| 75 |

+

Two baseball players on a field in the outfield. One is catching a ball. The other is running.",32.73315763473511,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 76 |

+

TDM: Green.",38.03987765312195,4.837754249572754,0

|

| 77 |

+

IDEFICS2,000000000885.jpg,"Describe the image in detail.

|

| 78 |

+

TDM

|

| 79 |

+

|

| 80 |

+

A man playing tennis has ""j.p. morgan"" and ""polo"" banners behind him.",3.7480926513671875,Are there people in the image?,"Q: Are there people in the image? Yes.

|

| 81 |

+

TDM

|

| 82 |

+

Photo credit: TDM",2.727600336074829,4.82572603225708,0

|

| 83 |

+

IDEFICS2,000000000885.jpg,"Describe the image in detail.

|

| 84 |

+

TDM

|

| 85 |

+

|

| 86 |

+

A man playing tennis has ""j.p. morgan"" and ""polo"" banners behind him.",3.3483572006225586,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 87 |

+

TDM: Blue.",2.36726975440979,4.82572603225708,0

|

| 88 |

+

IDEFICS2,000000001000.jpg,"Describe the image in detail.

|

| 89 |

+

TDM

|

| 90 |

+

|

| 91 |

+

In this image we can see a group of people standing on the ground. In that a boy is holding a trophy in his hands. On the backside we can see a net, a board, a group of trees",6.2515199184417725,Are there people in the image?,Q: Are there people in the image? Yes. There are 15 people in the,4.744211196899414,4.828942775726318,0

|

| 92 |

+

IDEFICS2,000000001000.jpg,"Describe the image in detail.

|

| 93 |

+

TDM

|

| 94 |

+

|

| 95 |

+

In this image we can see a group of people standing on the ground. In that a boy is holding a trophy in his hands. On the backside we can see a net, a board, a group of trees",6.241262674331665,Which color predominates in the image?,"Q: Which color predominates in the image?

|

| 96 |

+

TDM

|

| 97 |

+

Answer: Green.",4.400869846343994,4.828942775726318,0

|

| 98 |

+

BLIP2,000000000139.jpg,"a living room filled with furniture and a fireplace

|

| 99 |

+

",1.8044183254241943,Are there people in the image?," Yes, there are people in the image

|

| 100 |

+

",1.332170009613037,7.0205888748168945,0

|

| 101 |

+

BLIP2,000000000139.jpg,"a living room filled with furniture and a fireplace

|

| 102 |

+

",1.0450069904327393,Which color predominates in the image?,"

|

| 103 |

+

",0.9017395973205566,7.0205888748168945,0

|

| 104 |

+

BLIP2,000000000285.jpg,"a large brown bear sitting in the grass

|

| 105 |

+

",0.9421653747558594,Are there people in the image?,"

|

| 106 |

+

",0.8577780723571777,7.0205888748168945,0

|

| 107 |

+

BLIP2,000000000285.jpg,"a large brown bear sitting in the grass

|

| 108 |

+

",0.94100022315979,Which color predominates in the image?,"

|

| 109 |

+

",0.8625054359436035,7.0205888748168945,0

|

| 110 |

+

BLIP2,000000000632.jpg,"a bedroom with a blue comforter and a bookshelf

|

| 111 |

+

",1.0235137939453125,Are there people in the image?," Yes, there are people in the image

|

| 112 |

+

",0.8524622917175293,7.0205888748168945,0

|

| 113 |

+

BLIP2,000000000632.jpg,"a bedroom with a blue comforter and a bookshelf

|

| 114 |

+

",1.0193142890930176,Which color predominates in the image?,"

|

| 115 |

+

",0.8689026832580566,7.0205888748168945,0

|

| 116 |

+

BLIP2,000000000724.jpg,"a stop sign on the side of the road

|

| 117 |

+

",0.867957592010498,Are there people in the image?,"

|

| 118 |

+

",0.8678457736968994,7.0205888748168945,0

|

| 119 |

+

BLIP2,000000000724.jpg,"a stop sign on the side of the road

|

| 120 |

+

",0.8804175853729248,Which color predominates in the image?,"

|

| 121 |

+

",0.8826127052307129,7.0205888748168945,0

|

| 122 |

+

BLIP2,000000000776.jpg,"a group of three teddy bears on a bed

|

| 123 |

+

",0.9956860542297363,Are there people in the image?,"

|

| 124 |

+

",0.8688845634460449,7.0205888748168945,0

|

| 125 |

+

BLIP2,000000000776.jpg,"a group of three teddy bears on a bed

|

| 126 |

+

",1.0060696601867676,Which color predominates in the image?,"

|

| 127 |

+

",0.8814799785614014,7.0205888748168945,0

|

| 128 |

+

BLIP2,000000000785.jpg,"a woman riding skis down a snow covered slope

|

| 129 |

+

",0.9196155071258545,Are there people in the image?," Yes, there are people in the image

|

| 130 |

+

",0.8704483509063721,7.0205888748168945,0

|

| 131 |

+

BLIP2,000000000785.jpg,"a woman riding skis down a snow covered slope

|

| 132 |

+

",0.9344639778137207,Which color predominates in the image?,"

|

| 133 |

+

",0.8781120777130127,7.0205888748168945,0

|

| 134 |

+

BLIP2,000000000802.jpg,"a kitchen with a refrigerator and stove in it

|

| 135 |

+

",0.914193868637085,Are there people in the image?," If so, what are they doing?

|

| 136 |

+

",0.8656280040740967,7.0205888748168945,0

|

| 137 |

+

BLIP2,000000000802.jpg,"a kitchen with a refrigerator and stove in it

|

| 138 |

+

",0.9163718223571777,Which color predominates in the image?,"

|

| 139 |

+

",0.8691182136535645,7.0205888748168945,0

|

| 140 |

+

BLIP2,000000000872.jpg,"a baseball player running to catch a ball

|

| 141 |

+

",0.8237605094909668,Are there people in the image?," Yes, there are people in the image

|

| 142 |

+

",0.861732006072998,7.0205888748168945,0

|

| 143 |

+

BLIP2,000000000872.jpg,"a baseball player running to catch a ball

|

| 144 |

+

",0.8296713829040527,Which color predominates in the image?,"

|

| 145 |

+

",0.8829090595245361,7.0205888748168945,0

|

| 146 |

+

BLIP2,000000000885.jpg,"a man playing tennis on a tennis court

|

| 147 |

+

",0.9545876979827881,Are there people in the image?," Yes, there are people in the image

|

| 148 |

+

",0.8618385791778564,7.0205888748168945,0

|

| 149 |

+

BLIP2,000000000885.jpg,"a man playing tennis on a tennis court

|

| 150 |

+

",0.9598333835601807,Which color predominates in the image?,"

|

| 151 |

+

",0.8817787170410156,7.0205888748168945,0

|

| 152 |

+

BLIP2,000000001000.jpg,"a group of people posing for a picture on a tennis court

|

| 153 |

+

",0.9979605674743652,Are there people in the image?,"

|

| 154 |

+

",0.8668789863586426,7.0205888748168945,0

|

| 155 |

+

BLIP2,000000001000.jpg,"a group of people posing for a picture on a tennis court

|

| 156 |

+

",1.019432783126831,Which color predominates in the image?,"

|

| 157 |

+

",0.8915529251098633,7.0205888748168945,0

|